La historia de la computación moderna está marcada por momentos en los que una arquitectura redefine los límites de lo posible. A un año de su anuncio, Blackwell, la arquitectura de NVIDIA presentada en 2024, es uno de esos puntos de inflexión. Diseñada para suceder a Hopper, promete una revolución en el cálculo acelerado, sobre todo en aplicaciones de inteligencia artificial generativa. Y no es una promesa menor: según datos oficiales, Blackwell podría ser entre 2 y 4 veces más eficiente que su predecesora, todo mientras reduce el consumo energético.

Una arquitectura construida para la nueva IA

El chip insignia de esta familia es el GB200, un coloso que combina dos die GPU y un die de CPU en un solo paquete, unidos por la tecnología NVLink-C2C (chip-to-chip). La idea detrás de este diseño es clara: eliminar los cuellos de botella que limitaban el ancho de banda y la eficiencia cuando se conectaban varias GPUs.

Con Blackwell, NVIDIA introduce un nuevo módulo: GB200 Grace Blackwell Superchip, que une una CPU Grace (basada en ARM) con la potencia de dos GPUs Blackwell. Es el corazón del sistema DGX GB200, pensado para grandes centros de datos, modelado de lenguaje a gran escala, simulaciones científicas y entrenamientos multimodales.

Rendimiento que rompe escalas

NVIDIA afirma que un sistema DGX GB200, que integra 72 chips Blackwell, puede ejecutar modelos con hasta 27 billones de parámetros. En comparación, GPT-4 se estima en poco más de 1 billón. Esa capacidad no sólo acelera la IA generativa, sino también la capacidad de inferencia en tiempo real, algo clave para aplicaciones en salud, robótica, visión por computadora o ciberseguridad.

El nuevo motor de transformadores incorporado, junto con un sistema mejorado de gestión de memoria y cálculo mixto, permite optimizar tareas con gran carga de tensores. Se estima que el rendimiento en inferencia de modelos como LLaMA 2 o GPT-J se multiplica por 4, con la mitad del consumo que en Hopper.

Ventajas técnicas de Blackwell:

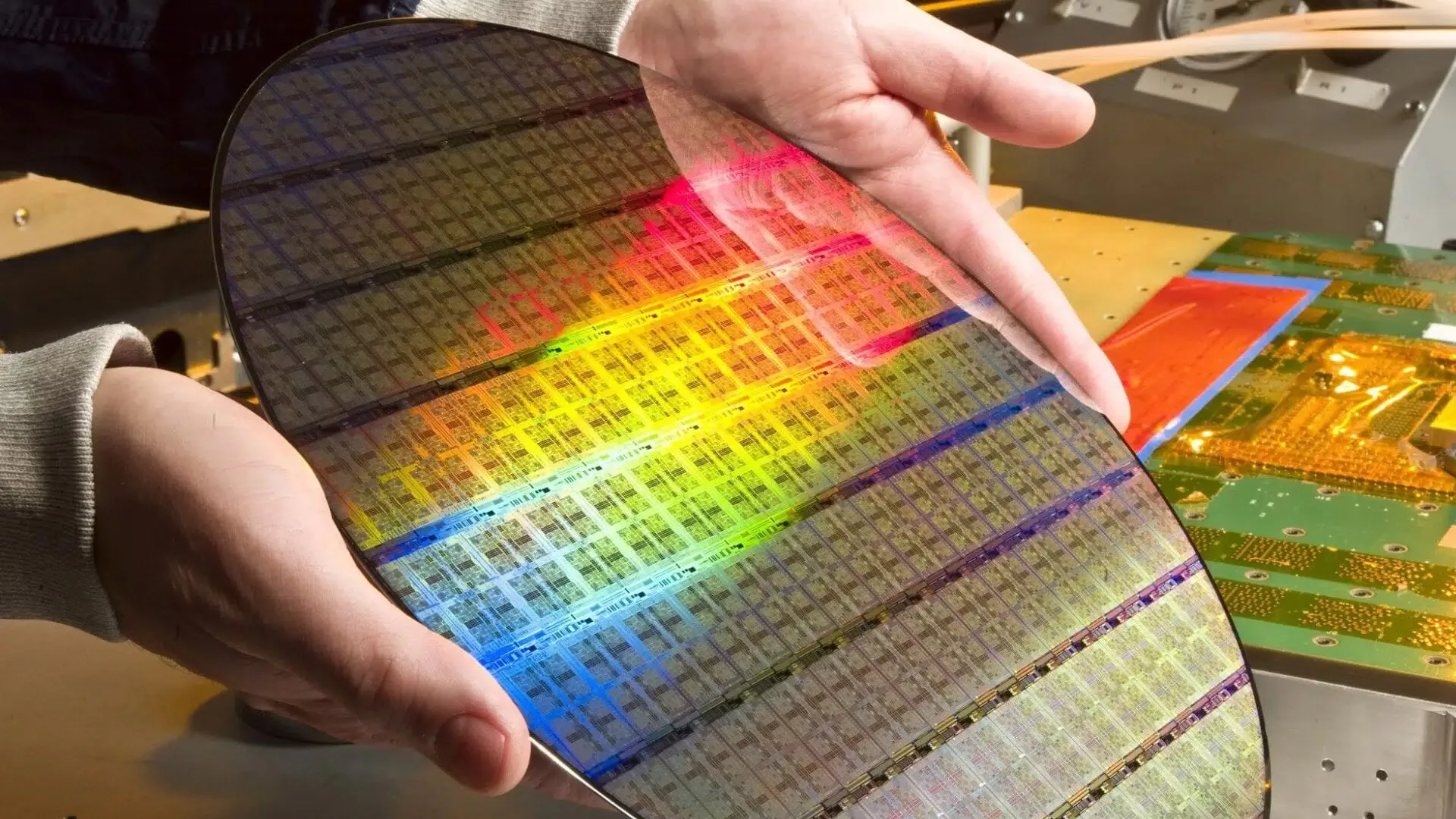

- Proceso de fabricación en 4nm de TSMC, con interposers y memoria HBM3E, que permite hasta 192 GB por módulo.

- NVLink 5.0, con un ancho de banda de hasta 1,8 TB/s entre GPUs.

- Soporte nativo para FP4, lo que mejora la eficiencia energética sin sacrificar precisión en redes neuronales.

- Arquitectura modular escalable, ideal para sistemas como NVIDIA DGX, HGX o plataformas de supercomputación.

Una jugada geopolítica y empresarial

NVIDIA no juega sola. El lanzamiento de Blackwell ocurre en un contexto donde EE.UU. impone restricciones a la exportación de chips de alto rendimiento a China, y donde empresas como AMD (con MI300X) e Intel (con Gaudi 3) también buscan su parte del pastel.

Sin embargo, NVIDIA sigue marcando el ritmo. Empresas como Amazon, Google, Meta y Microsoft ya anunciaron que integrarán sistemas basados en Blackwell en sus nubes. Y eso, en el juego de la IA generativa, equivale a dominar el escenario.

Aunque está pensada para IA, Blackwell también encuentra aplicación en simulaciones de clima, física cuántica, secuenciación genética y otros ámbitos del HPC (High Performance Computing). Su versatilidad la convierte en una arquitectura fundacional para la próxima década.

Con precios que superan ampliamente los USD 30.000 por unidad (y pueden alcanzar cifras mucho mayores en configuraciones DGX completas), Blackwell no está pensada para usuarios domésticos. Pero lo que ocurra en sus centros de datos modelará el software, la ciencia y la economía digital en los próximos años.

NVIDIA no sólo lanzó una nueva arquitectura. Lanzó una declaración de intenciones: si la IA es el nuevo petróleo, Blackwell es su infraestructura. Un ejemplo destacado es la introducción de la plataforma NVIDIA Blackwell, que ha establecido nuevos estándares en rendimiento y eficiencia energética para la inferencia de IA. En las pruebas más recientes de MLPerf Inference V5.0, la plataforma Blackwell demostró mejoras sustanciales en el rendimiento, superando a generaciones anteriores y a productos de la competencia.

Además, empresas líderes en tecnología han adoptado la plataforma Blackwell Ultra de NVIDIA. Se espera que productos basados en Blackwell Ultra estén disponibles a partir de la segunda mitad de 2025, con socios como Cisco, Dell Technologies y Hewlett Packard Enterprise planificando ofrecer servidores basados en esta tecnología.

Estos desarrollos en hardware están facilitando la implementación y el rendimiento de modelos fundacionales más complejos y eficientes, acelerando su adopción en diversas industrias y aplicaciones