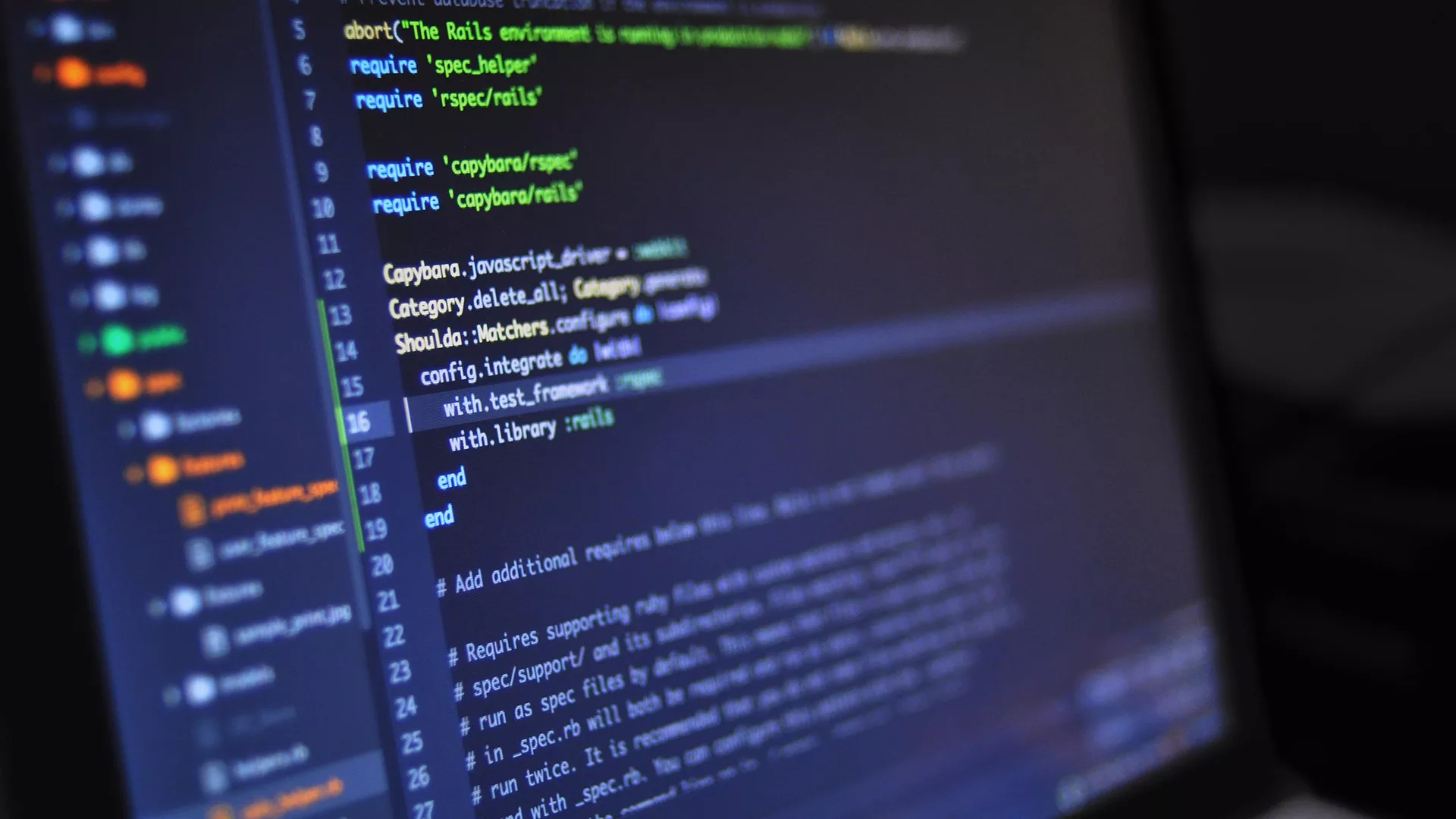

Meta ha revelado su más reciente innovación, Code Llama, una inteligencia artificial diseñada para redactar y mejorar código de programación. Aunque existen otros bots con IA, como ChatGPT y Bard, que pueden escribir código, Code Llama se destaca por sus características diseñadas específicamente para facilitar el trabajo de los programadores.

Esta herramienta de inteligencia artificial de Meta no solo interpreta instrucciones dadas en lenguaje natural, sino que también trabaja con segmentos de código existentes. Su fundamento se basa en Llama 2, un avanzado modelo de lenguaje que la firma presentó hace algunos meses. Notablemente, Code Llama es versátil, siendo compatible con lenguajes de programación ampliamente utilizados, como Python, Javascript, PHP, C++, C# y Bash.

Una de las ventajas de usar Code Llama es su capacidad para completar secciones de código, identificar fallos y sugerir correcciones. De forma impresionante, también puede proporcionar descripciones claras y comprensibles de fragmentos de código.

Modelos adaptados a distintas necesidades

El equipo detrás de Code Llama ha desarrollado tres variantes del software. El modelo principal se centra en la creación de código. Por otro lado, Code Llama-Python se ha optimizado específicamente para el lenguaje Python. Además, hay un modelo llamado Code Llama-Instruct, diseñado para interpretar instrucciones dadas en lenguaje cotidiano.

Es importante destacar que desde Meta aconsejan no utilizar Code Llama o Code Llama-Python cuando las entradas son instrucciones en lenguaje natural. Estos modelos están diseñados principalmente para trabajar con código. En cambio, Code Llama-Instruct ha sido desarrollado para «captar con precisión las expectativas de los usuarios a partir de sus instrucciones».

En función de las necesidades de la tarea, Code Llama se ofrece en tres tamaños distintos: uno con 7.000 millones de parámetros, otro con 13.000 millones y el más robusto con 34.000 millones.

Todos estos modelos se entrenaron utilizando 500.000 millones de tokens relacionados con programación. La principal diferencia entre ellos es la velocidad de respuesta y la profundidad de los resultados. Por ejemplo, la versión de 7.000 millones de parámetros es ideal para tareas rápidas como completar líneas de código en máquinas con una GPU. Mientras que la de 34.000 millones de parámetros es más detallada y precisa, aunque no está destinada para trabajos en tiempo real.